黑林错觉让AI一秒变傻?

这种能欺骗机器的图片还有个名字,叫对抗样本。我们可以把对抗样本理解为一种攻击机器视觉的“病毒”。

钛媒体作者丨脑极体

在AI技术构建出的未来世界蓝图中,有大量装置是通过机器视觉这一最基础的技术实现的。GPU的广泛应用给了机器快速处理图片的能力,神经网络让机器可以理解图片。

正因如此,我们才能够通过摄像头分辨眼前这张脸是不是iPhoneX的主人、从监控录像中找到犯罪分子的身影,以及自动分辨社交网站上的某张照片是否涉嫌有色情内容。

不过机器视觉和人类视觉有着很大的差异,比如说在出现误差方面,机器和人类就有很多不同。比如人类视觉往往会因为线条的排列分布而分不清究竟是直线还是曲线。

(著名的黑林错觉)

但机器视觉的错觉,往往要比人类的有趣得多。

如何欺骗愚蠢的机器视觉?

大家一定听说过一个“欺骗”深度学习神经网络的例子,只需改变几个像素,就能得到差异巨大的结果。

就像这张照片,前一秒神经网络还有57.7%的把握认为它是一只熊猫,可在经历过一点点处理后,神经网络竟然99.3%的把握认为这是一只长臂猿。可对人类来说,这两张照片几乎没有区别。

出现这种情况的原因是,人类和机器有关“视觉”的概念是很不一样的。人类的视觉来自于对事物的整体理解,建立于长久以来对世界的认识之上。我们看到毛茸茸的东西就会认为是动物,看到羽毛就会认为是鸟。这样的模式让我们的视觉是感性甚至模糊的,不光可以分辨我们认识的物品,甚至可以去分辨我们从没见过的物品。

但机器的视觉模式就很不同了,机器学习算法本质上是一个分类器,通过层层神经网络去分辨一张图片是不是猴子、是不是水杯、是不是电脑、是不是……最后输出结果,告诉人们这张照片有90%的可能是水杯,还有40%的可能是一颗树。

这时要想让机器产生错觉就很容易了。假如我们想要让机器把水杯“看成”树,就要找到机器眼中两种物品的临界点。一张图片在机器眼中,只是无数像素点的排列,如果轻微的改变这些像素的排列,让他们越过这个临界点,机器就会犯错。

结果就是,要不机器会把两张人眼中完全一样的图片看成两种完全不同的东西,要不会把一张不知所云的图片看成物品或动物。

对抗样本:让机器变糊涂的新病毒

这种能欺骗机器的图片还有个名字,叫对抗样本。我们可以把对抗样本理解为一种攻击机器视觉的“病毒”,面对不同的机器学习算法会有不同的样本生成方式,最终目的只有一个,那就是混淆机器的视觉。

可怕的是,目前还没有什么好的方式去解决这种病毒。只能不断的自己生成样本进行对抗,或者不断压缩模型类别标签的大小,让攻击者难以找到其中的临界点。

不过我们也不必对这种病毒太过恐惧,目前大部分对抗样本为了加强机器视觉的精确度而特地生成的。很难自然发生在现实应用场景中,毕竟你不能改变自己脸上的像素点分布。

尤其当对方不能直接访问算法模型时,制造出对抗样本的成本也会很高。举个例子说,如果有博主想依靠在社交媒体上发布色情内容来盈利,就要首先训练出一个能对所有图片进行微调,并且还能欺骗过社交媒体审核算法的对抗模型。再对每天需要发布的图片进行处理。有这个时间、金钱成本和技术,早就可以去AI初创企业拿百万年薪了。

所以,我们大可不必担心对抗样本会对现实产生什么影响。直到一群来自Google的专家又想出了产生对抗样本的新方法。

让AI一秒变傻的迷幻药

看到以上的几个图案,人类会有什么感觉?或许会认为是哪个新锐艺术家的“迷幻大作”吧。

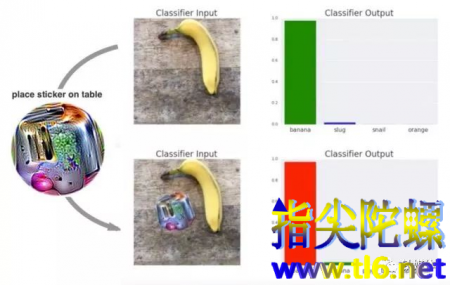

可机器看到这些图案,会立刻被迷的晕头转向,分不清眼前的图案就是是什么了。Google的专家做了一组实验,把这些小圆图案放到机器能分辨的图片上,机器就会立刻给出不同的答案。

如图所示,前一秒机器还能看出这是一根香蕉,加上这个小圆片之后,机器就笃定这是一台吐司机。

其中的原理是,神经网络识别物体依靠的是图片中的特征,只要某一分类的特征浓度够高,神经网络就会忽略其他因素,直接给出答案。这些迷幻的小圆片,可以被理解为某一种物体特征的高度浓缩,出现在图片中时,神经网络就会立刻被这些特征吸引,忽略图片中的其他信息。

也就是说,过去我们需要经过复杂的处理才能让某一张图片欺骗神经网络,现在我们可以把这些小圆片批量加入到图片当中,让他们去批量欺骗神经网络。

想逃过AI的眼睛,只需一张神奇的小贴纸

这样一来,事情的发展就变得很恐怖了。

首先,制作对抗样本一下子变成了一种成本极低的事情,可能只要一张贴片,就能欺骗过整个模型。在上述的色情图片审核案例中,我们就找到了一个很好的解决方案。更可怕的是,如果用机器视觉来检测毒品、武器等等,是不是也能用这种方式逃之夭夭?

更可怕的是,这种方式可能让对抗样本进入物理世界。以往我们不能改变真实世界中的像素点,但如果把这些小图案变成贴纸粘在各个地方,或许就可以改变很多东西。

例如自动驾驶通过摄像头来识别交通标示,如果在限速、停止牌上都贴上贴纸,驾驶系统会不会将其视若无物,让整个世界乱套?而犯罪分子想要让自己的面孔从天网中逃离,也不必像《换脸》中一样动刀整容,只要在脸上贴张贴纸,就变成了行走的吐司机。

当然了,这几张贴纸也无非是提出了一种可能而已,并不是现在就可以利用它们做什么坏事。但这场实验告诉了我们,AI的安全程度比我们想象中要更低。让AI进入物理世界,恐怕还要再多做点准备呢。